L'idée d'insuffler la vie à une machine et lui permettre notamment de penser par elle même, ne date pas d'hier. L'idée est en effet intimement liée à l'apparition des premiers ordinateurs vers 1943. Ceux-ci permettant une nouvelle puissance de calcul mais aussi l'amélioration des façons de calculer de l'époque (gains de temps, moins d’erreurs ...).

Les premières machines à calculer :

A l'origine, le boulier inventé vers l'an 700 constitue la première façon de calculer intelligemment.

Plus proche de notre époque, vint le logarithme que l'on attribue généralement à l'écossais John NEPER. En effet c'est en 1614 que celui-ci démontra que la multiplication et la division pouvaient se ramener à une série d'additions. Ceci permit dès 1620 l'utilisation de la règle à calcul.

Pour autant le vrai père de cette théorie est un savant arabe (pour vous éviter son nom : « Mohamed Ybn Moussa Al-KHAWAREZMI » ) également à l'origine de l'Algèbre, activité ayant dès lors permis de résoudre des systèmes complexes basés sur la recherche d'une variable inconnue X afin d'équilibrer les calculs.

Puis historiquement :

Ce n'est qu'en 1642 que fut créé par Blaise Pascal la première machine à calculer dite machine d'arithmétique, baptisée par son créateur : la Pascaline.

Cette machine(que vous pouvez voire sur l'image ci dessu), fruit d'un assemblage d'engrenage, était capable d'effectuer des additions et des soustractions, et destinée à l'origine à aider le père du jeune créateur, un percepteur de taxes...

Ce fut le premier pas dans la réalisation d'une IA. Une machine était capable de faire ce que seul un homme pouvait alors effectuer.

Leibnitz proposa en 1673 une amélioration de la Pascaline en lui dotant de deux nouvelles fonctions : la multiplication et la division.

En 1738, Jacques de Vaucanson apporta une première avancée notable dans la conception d'automates. C’est son célèbre canard qui avait l'étonnante capacité de bouger, cancaner, barboter, boire et digérer comme un véritable canard ; le tout programmable grâce à un mécanisme interne de pignons.

Enfin 1834 constitue un tournant majeur : Charles Babbage apprend qu'une machine à tisser est programmée à l'aide de cartes perforées. Il se lance donc dans la construction d'une machine à calculer exploitant cette idée révolutionnaire.

Les premières vagues d'ordinateurs :

C'est en 1820 qu'apparaissaient les premiers calculateurs mécaniques. Ceux-ci possédaient alors quatre fonctions de base : l'addition, la soustraction, la multiplication et la division.

Conformément à l'idée de Charles Babbage (cf. plus haut) le premier ordinateur programmable qui suivi fonctionnait en batch. C'est à dire avec des cartes perforées. On apportait son lot (batch) de cartes perforées contenant le programme puis un opérateur insérait les lots de cartes en attente dans l'ordinateur qui alors faisait tourner le programme et donnait le résultat le plus souvent sur une imprimante. L'utilisateur ne récupérait généralement le résultat que le lendemain, le temps que son lot de cartes passe dans l'ordinateur.

Ces cartes perforées sont fréquemment considérées, et à juste titre, comme les prémisses de la programmation par ordinateur. Leur fonctionnement, des plus rudimentaires, n’empêchait pas d'être fonctionnel. Une série de cartes, attachée les unes aux autres formant une bande de plusieurs mètres, était préalablement trouées à des emplacements stratégiques. Ces trous constituaient, une fois rentrés dans l'ordinateur une suite logique d'instructions à interpréter et composaient le programme dans son intégralité. Ces trous était un langage à part entière compris par l'ordinateur.

La suite est bien connue du grand public. Nous sommes passé, en un demi-siècle, des ordinateurs encombrants de la taille d'un amphithéâtre, à des ordinateurs «personnels» accessibles aux particuliers et qui aujourd'hui d’ailleurs équipent la plupart des familles :

Maintenant que l'électronique a fait des progrès suffisants et que les premiers calculateurs ont fait leurs preuves, les ordinateurs vont pouvoir apparaître en masse, nés du besoin de réaliser des opérations de plus en plus complexes.

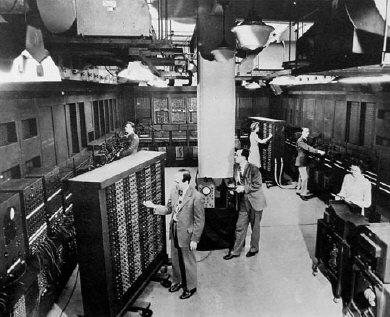

En 1943, le premier ordinateur ne comportant plus aucune pièce mécanique est créé par P. Eckert et J. Mauchly : l'ENIAC (Electronic Numerical Integrator And Computer). Il est composé de 18000 lampes à vide, occupe une place de 1500 m² et pèse plus de 30 tonnes. Sa vitesse de calcul : environ 330 multiplications par seconde et fut utilisé pour mettre au point la bombe H.

Son principal inconvénient était sa programmation : l'ENIAC était en effet uniquement programmable manuellement avec des commutateurs ou en recablant entre eux ses différents éléments.

Anecdote : La première erreur informatique est due à un insecte qui, attiré par la chaleur, était venu se loger dans les lampes et avait créé un court-circuit. Ainsi le terme anglais pour « insecte » étant « bug », le nom est resté pour désigner une erreur informatique. Le terme bug a été francisé par la suite en bogue.

Le transistor

En 1948, le transistor est créé dans les laboratoires de la firme Bell Labs (grâce aux ingénieurs John Bardeen, Walter Brattain et William Shockley). Il permet dans les années 50 de rendre les ordinateurs moins encombrants, moins gourmands en énergie électrique et donc moins coûteux. C'est la révolution dans l'histoire de l'ordinateur qui vaudra l'apparition des micro-ordinateurs apparue dès 1971 dont les fameux ordinateurs personnels accessibles à la population car plus petits que leurs ancêtres. (Il se trouve que mon père a eu son premier ordinateur personnel, l'un des premier, en 1981 : un Commodore fourni avec un programme d’échec. Une chose encore assez rare à l'époque, du moins dans les ménages français.)

Deep Blue d'IBM est le premier ordinateur à battre un champion du monde d'échecs en titre (Garry Kasparov) en 1990.

Toutefois Deep Blue reste un simple calculateur évaluant 200 millions de positions à la seconde, sans conscience du jeu lui-même et faisant donc appel à la puissance de calcul plus que de l'intelligence artificielle à proprement parler.